Xinference+Ollama+Dify搭建本地知识库

1.xinference安装和启动

配置过程具体过程可以参考前面教程,然后启动xinference服务:

>> xinference-local --host 0.0.0.0 --port 9997

2.xinference配置嵌入和rerank模型

2.1 启动模型

首先,登录xinference的ui界面:ui界面地址;然后 Launch Model,选择 EMBEDDING MODELS,并配置 bge-large-zh-v1.5模型;最后,选择 RERANK MODELS,并配置 bge-reranker-v2-m3模型。

2.2 获取模型配置

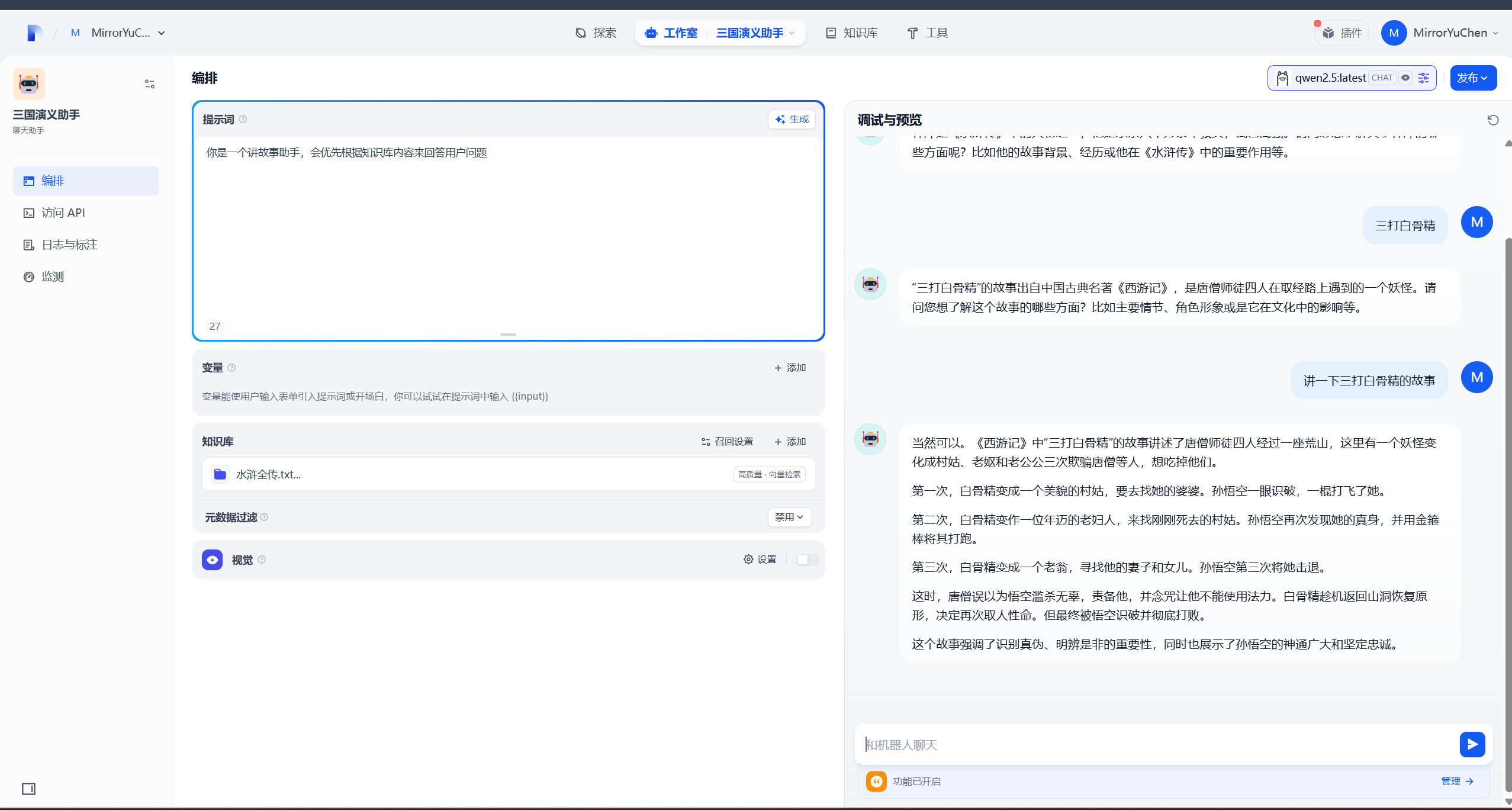

首先,选择 Running Models==>EMBEDDING MODELS查看:

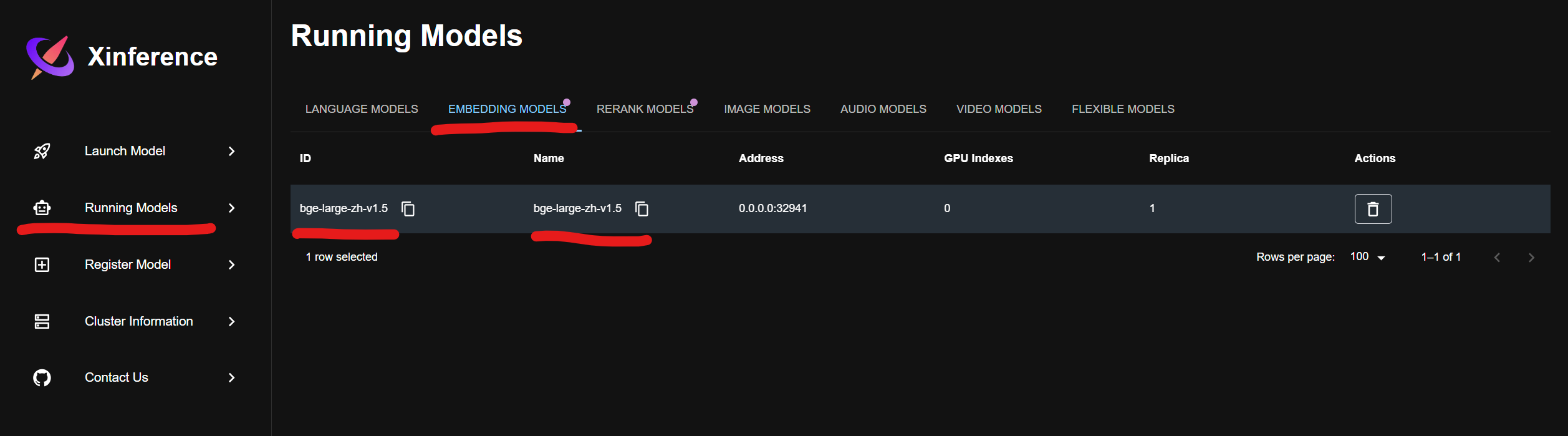

然后,选择 Running Models ==> RERANK MODELS查看:

3.dify配置

3.1 配置xinference部署模型

首先,进入dify界面:http://localhost/apps;然后,右键单击右上角角色图标,进入 设置;其次,选择模型供应商,配置 Xorbits Inference(没有安装的话,先安装一下);最后,添加模型 Text Embedding和 Rerank相关模型:

- (1)

Text Embedding配置,这个根据步骤二中获取到的模型配置来进行配置:

模型名称:bge-large-zh-v1.5

服务器URL:http://localhost:10086

模型UID:bge-large-zh-v1.5

- (2)

Rerank配置,这个也根据步骤二中获取到的模型配置来进行配置

模型名称:bge-reranker-v2-m3

服务器URL:http://localhost:10086

模型UID:bge-reranker-v2-m3

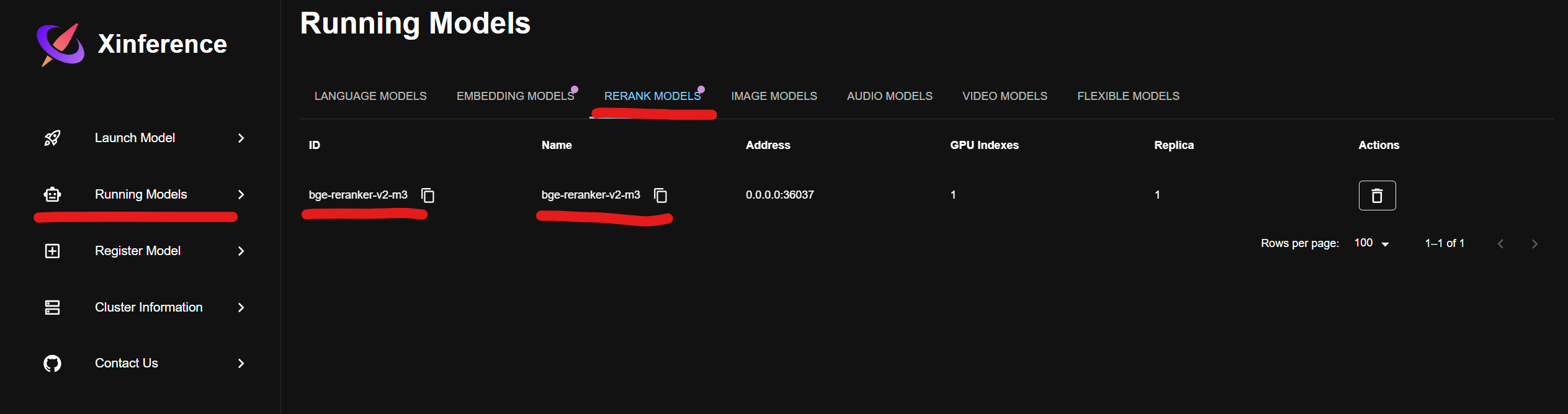

3.2 创建知识库

”知识库“ -> ”创建知识库“ -> "导入已有文本" -> ”上传文本文件“ -> ”下一步“ :

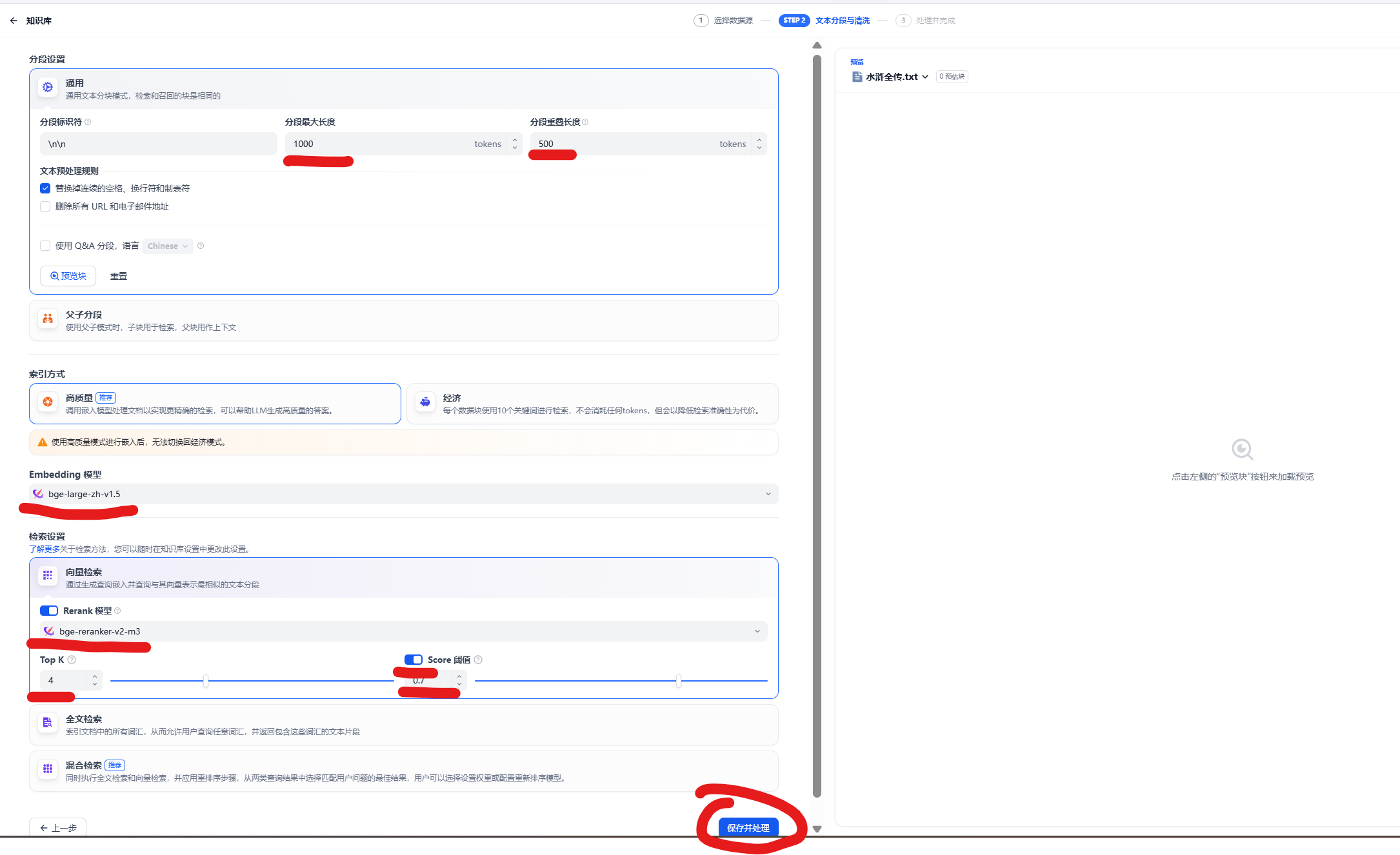

3.3 知识库配置

配置分段最大长度为1000,分段重叠长度为500,Embedding模型为 bge-large-zh-v1.5,Rerank模型为 bge-reranker-v2-m3:

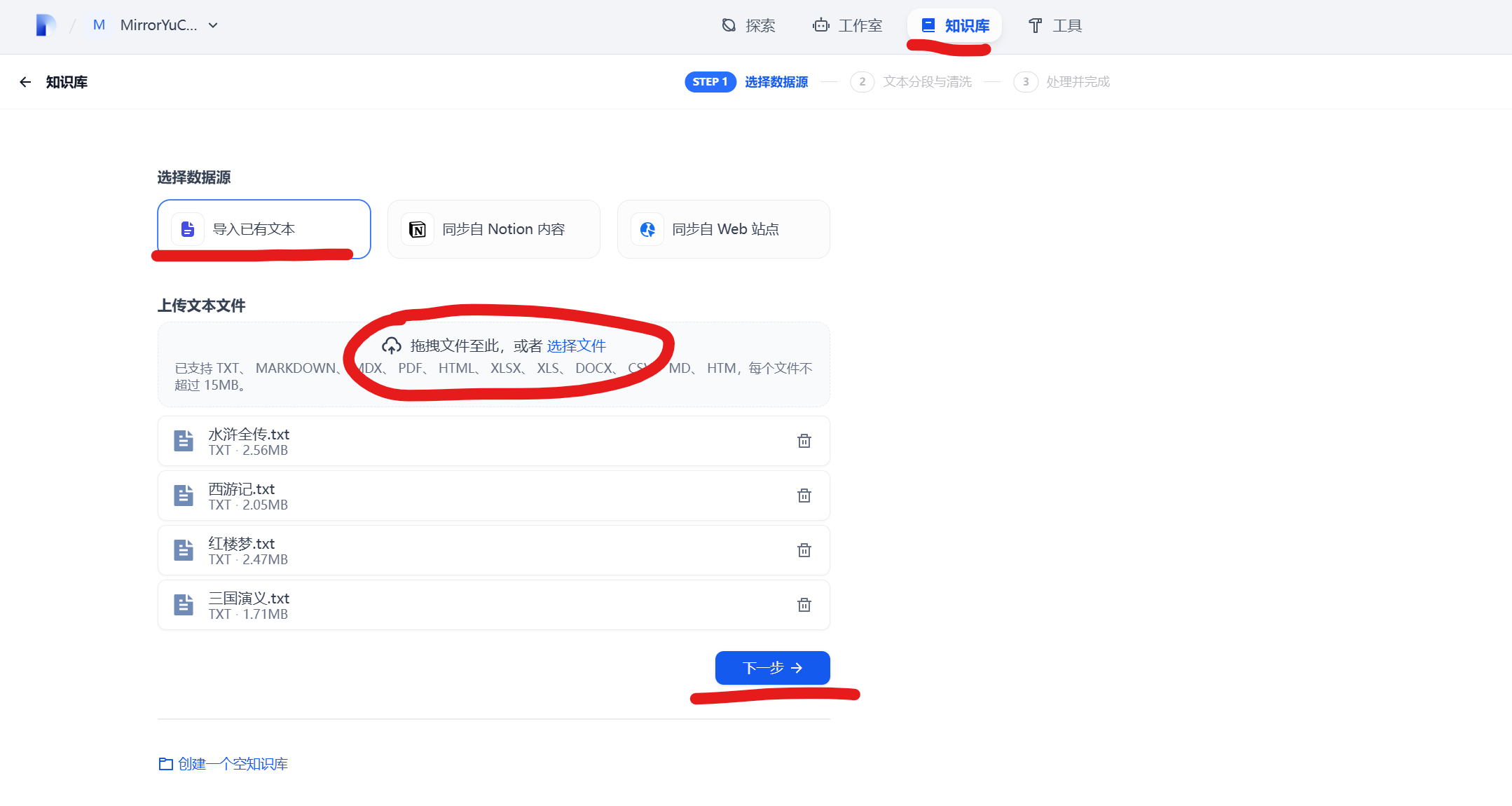

3.4 智能体配置

创建一个智能体,配置提示词和知识库,然后对话即可: